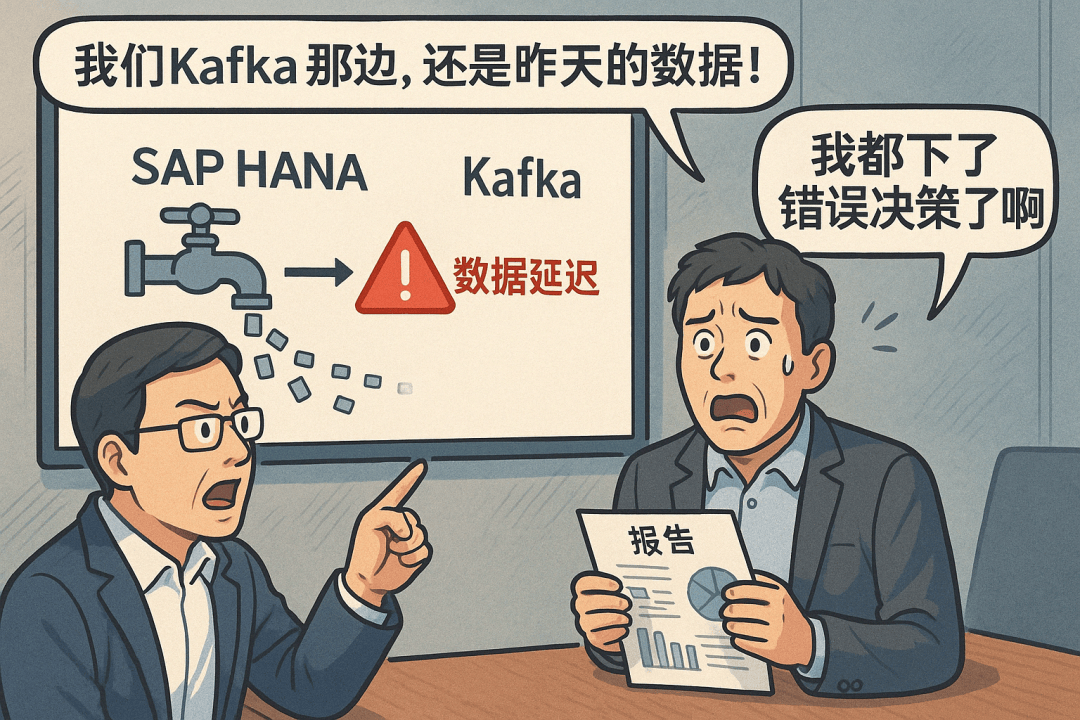

在数字化时代,数据就像血液,企业就是在数据中“奔跑的巨人”。但如果数据流转慢了、卡了、断了——企业运营就像瞎子摸象。尤其是SAP HANA数据库环境下,要把数据实时推送到Kafka消息队列中,困难指数直接飙升。

作为一家行业领先的燃气能源企业,某企业致力于通过数字化转型提升运营效率和决策能力。然而,随着业务不断扩展,该公司面临着大量生产数据的实时同步需求,尤其是在SAP HANA数据库和Kafka消息队列之间的高效数据同步问题。

为此,该企业亟需寻求一种能够高效、稳定地进行数据同步的解决方案,以确保业务决策能够基于实时数据进行,并减少数据同步对生产系统的影响。

两次尝试未果,问题出在哪?

为了搞定SAP到Kafka的数据同步,这家企业先后尝试了两种方案,但都未能顺利落地实现。

方案一:SAP Data Intelligence Cloud 与 Kafka

方案一采用了SAP原厂的Data Intelligence Cloud工具,结合Kafka进行数据同步。虽然这一方案理论上能够提供数据同步的功能,但在实际应用中却暴露出以下问题:

- 生产性能影响较大:方案基于触发器机制,可能会对生产环境的性能产生较大影响,尤其是数据量庞大的情况下,触发器会带来明显的延迟。

- 配置和维护复杂:Data Intelligence Cloud是SAP提供的工具,其配置过程复杂且需要专业技术人员支持,且日常维护难度较大。

方案二:SAP原厂工具->MySQL/Oracle ->(第三方工具)Kafka

为了绕过方案一的不足,第二种方案采用了SAP原厂工具将数据同步到MySQL或Oracle数据库,再通过第三方工具将数据传输到Kafka。这一方案看似完善,但依然存在诸多问题:

- 多余的中间层:数据需要经过MySQL或Oracle的中转,增加了系统的复杂度和维护成本。

- 延迟和一致性问题:多层次的中转容易导致数据同步过程中的延迟,且无法保障数据的一致性,无法满足企业对于实时性和可靠性的高要求。

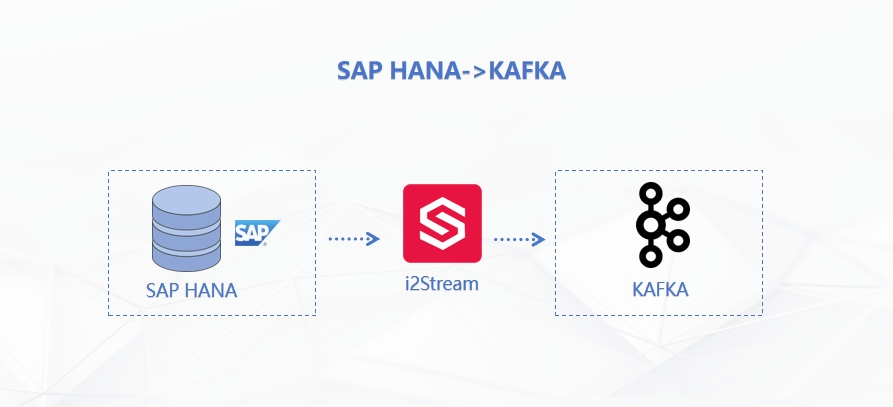

一招破局,英方i2Stream成功落地

在前两种方案未能奏效的情况下,该企业最终选择了英方i2Stream作为数据同步解决方案,方案通过直接分析HANA数据库日志获取变化数据,获得SAP HANA原厂支持,取得了显著的成功。

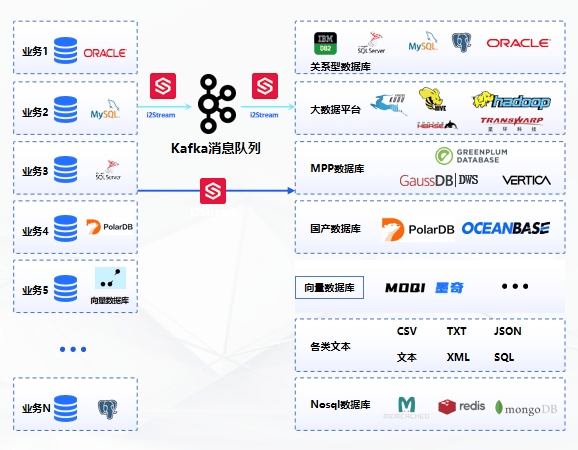

i2Stream通过高效解析源端数据库的联机日志,实时捕获数据变更,并结合流数据处理技术,实现同构及异构数据库间的高效实时数据同步,支持大数据平台,确保在高并发场景下也能实现秒级同步。不仅保障了数据的完整性和一致性,还实现了DML与DDL、数据与对象的一体化实时同步。

项目优势体现在以下几个方面:

最小化生产影响

与传统的触发器机制不同,i2Stream通过分析HANA数据库的日志变化来获取增量数据,从根本上减少了对生产系统的影响。这使得数据同步能够在不干扰业务正常运行的前提下,顺利进行。

高效的实时同步

i2Stream结合了SAP HANA的ODP(Operational Data Provisioning)技术,通过ODP_RESET、ODP_OPEN、ODP_FETCH等接口,实现了高效的增量数据同步。相较于传统的同步方式,i2Stream能够更快速、精准地将数据同步到Kafka,满足了实时性和高效性的双重要求。

灵活的定制化开发

针对客户的具体需求,英方i2Stream还提供了灵活的定制化开发能力。无论是数据同步频率的调整,还是特定数据格式的支持,i2Stream都能够根据实际情况进行灵活配置,确保同步过程的稳定性与可靠性。

最终,英方i2Stream通过调用JCO驱动ODQMON,结合ODP技术,成功实现了SAP HANA数据库到Kafka的增量数据同步。在这一过程中,i2Stream的高效性和稳定性得到了充分验证。配置简便、执行高效,不仅显著降低了对生产系统的影响,还确保了数据的准确性与实时性。

数据同步的每一个小细节,都会影响到企业的决策质量与运营效率。而英方i2Stream,则是企业数字化建设过程中不可或缺的得力助手。借助其强大的技术能力和高效的实时数据同步方案,企业不仅能够保持数据流动的高效性和一致性,还能在竞争中抢占先机,做出更加精准的业务决策。

目前产品已经支持Oracle、MySQL、SQLServer、PostgreSQL、DB2、Kudu、Hive、HBASE等数十种主流数据库,点击文末阅读原文,了解更多详情。

容灾产品

容灾产品 备份产品

备份产品 大数据产品

大数据产品 云数据管理

云数据管理

沪公网安备31011202020864号

沪公网安备31011202020864号